图像压缩为什么会导致图片模糊或失真

数字图像在传输与存储过程中常面临体积过大的困扰,压缩技术虽能有效缩减文件尺寸,却如同在羊皮纸上反复拓印,不可避免地导致细节磨损。当计算机视觉专家开发出JPEG标准时,他们或许未曾料到,这种以人类视觉特性为基础设计的算法,会在三十年后的高清时代暴露出明显的视觉缺陷。

算法原理限制

现代图像压缩算法多采用变换编码技术,其核心是对图像数据进行数学转换。离散余弦变换(DCT)将像素矩阵转换为频率系数矩阵时,就像把完整的拼图拆解成不同形状的碎片。高频分量对应图像的边缘和纹理细节,低频分量则代表平缓的色彩过渡。压缩过程中,算法会依据预设的量化表对这些系数进行取舍。

以JPEG标准为例,其量化表对高频分量的舍弃比例可达90%以上。麻省理工学院媒体实验室的研究显示,当压缩率超过10:1时,图像中相当于人类头发丝级别的细节信息就会永久丢失。这种选择性丢弃看似符合人眼对高频信息不敏感的特性,但在恢复图像时,缺失的高频成分会导致重建边缘出现振铃效应,形成肉眼可见的锯齿和模糊。

高频信息丢失

图像中的高频成分如同交响乐中的打击乐器,负责呈现物体的轮廓和纹理特征。压缩算法对高频信息的处理类似音频工程中的低通滤波器,会抹去超过特定阈值的细节。在手机拍摄的夜景照片中,这种效应尤为明显——原本清晰的灯光星芒在压缩后会退化成模糊的光斑。

斯坦福大学计算机图形学团队通过显微分析发现,即便采用无损压缩格式,某些图像传感器记录的原始光子分布信息也会在预处理阶段被简化。当摄影师使用连拍模式时,相机芯片为提升处理速度,会主动舍弃部分高频数据,这种前置的数据筛选为后续压缩埋下了质量隐患。

量化误差积累

量化过程如同用疏密不同的筛网过滤面粉,精细的筛网能保留更多颗粒,粗糙的筛网则让细粉流失。在压缩算法的色度抽样阶段,常见的4:2:0格式会将相邻四个像素的色度信息合并为一个平均值。这种处理在蓝天等均匀色块区域影响甚微,但遇到红绿相间的方格纹衬衫时,就会产生色彩渗染现象。

东京工业大学的研究人员构建了量化误差传播模型,证明多次重复压缩会产生误差叠加效应。社交媒体平台对用户上传图片进行的自动压缩-解压-再压缩处理链条,就像用复印机反复复印文件,每次循环都会加重图像的马赛克化程度。实验数据显示,经过五次JPEG压缩后,测试图像的峰值信噪比会下降12dB。

动态范围压缩

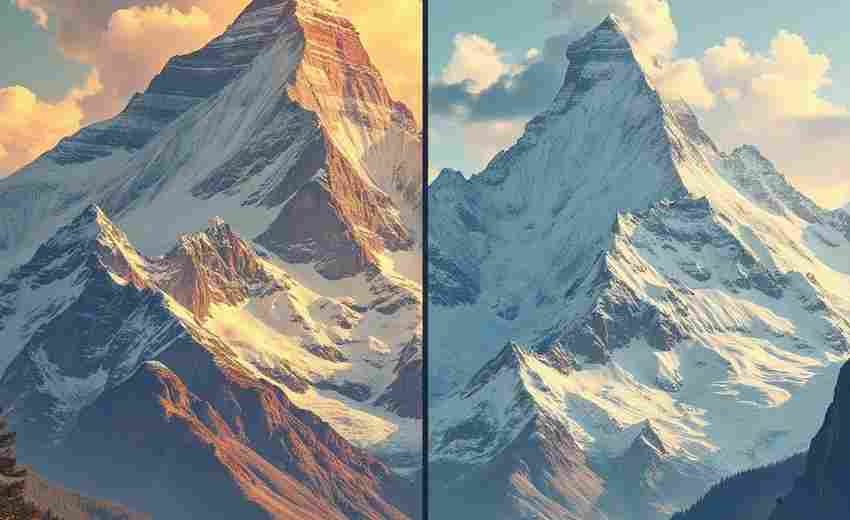

高动态范围(HDR)图像的压缩如同将交响乐改编为八音盒乐曲,必须舍弃部分音域。当算法将14bit的RAW格式转换为8bit的JPEG时,相当于把1000个亮度等级压缩到256个。这种非线性量化会导致阴影区域的色阶断裂,在渐变天空中出现肉眼可见的条带状伪影。

专业图像处理软件采用的dithering技术虽然能通过噪声扩散缓解色阶断裂,但在压缩过程中,这些精心添加的高频噪声往往会被当作冗余信息剔除。伦敦艺术大学视觉传播系的对比实验表明,经过压缩的dithering处理图像,其视觉效果甚至劣于未做处理的原始压缩图像。

感知特性差异

人眼视网膜中视杆细胞与视锥细胞的分布差异,使得我们对亮度变化的敏感度是色度变化的3倍。基于此特性设计的压缩算法,通常会对色度通道进行更激进的采样。这种优化在多数场景下有效,但当遇到特定色彩过渡时,会引发意料之外的失真——比如粉红色花瓣边缘出现的青色镶边。

神经科学的最新研究揭示,人类视觉皮层对特定方向的边缘特别敏感。而基于DCT的压缩算法对各方向边缘的均匀处理,恰好与人脑的感知机制存在错位。这种生物学特性与工程设计的错配,导致压缩图像在主观质量评价中往往得分低于客观指标预测值。

上一篇:图像修复是否属于图像恢复的范畴 下一篇:图吧导航避开收费站的操作步骤是什么