如何准确测量蓝牙耳机的音频延迟时间

随着无线音频技术的普及,蓝牙耳机的性能指标愈发受到关注。其中音频延迟作为影响用户体验的核心参数,往往成为产品评测的关键环节。专业测试数据显示,当前主流蓝牙耳机的延迟范围在50-400毫秒之间,这种差异直接关系到游戏操控同步率、视频口型匹配度等实际使用场景。如何建立科学的测量体系,已成为音频工程师和消费电子评测领域的重要课题。接下来将从五个维度展开分析。

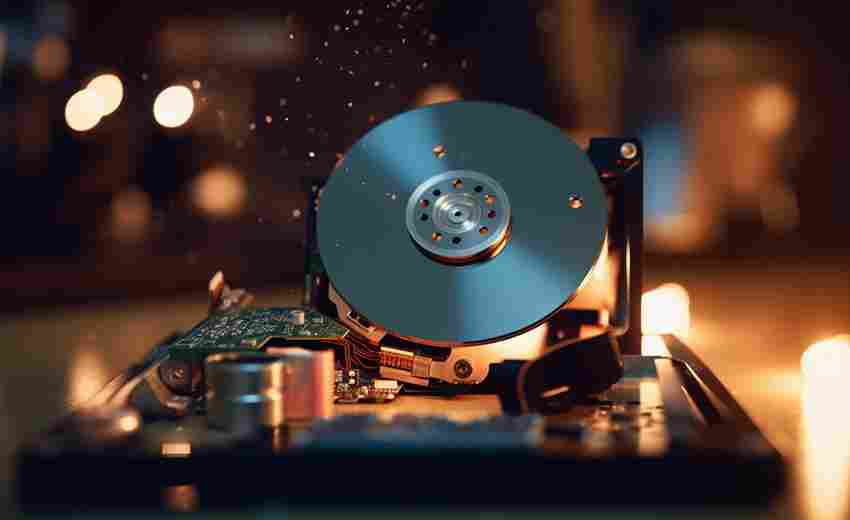

信号传输原理

蓝牙音频延迟的本质是数字信号编解码与无线传输的时间损耗。当音频源发出信号时,需经历AAC/SBC编码、射频调制、空间传播、接收解调、DAC转换等多个环节。根据IEEE 802.15.1协议标准,每个处理阶段都会产生10-80ms不等的时延积累。

索尼音频实验室2021年的研究表明,aptX低延迟编解码器相比传统SBC协议,可减少约40%的编解码时间。但这也取决于发射端与接收端的芯片协同能力,当设备采用不同品牌的主控芯片时,可能因握手协议差异额外产生15ms的协商延迟。

专业测量设备

精确测量需要构建闭环测试系统。德国Audio Precision公司的APx517B音频分析仪是行业标杆设备,其内置的延迟测量模块采用脉冲响应法,通过发射特定频率的测试音,用高精度示波器捕捉输入输出波形的时间差。该设备的时间分辨率可达0.01ms,满足专业级测试需求。

对于消费级检测,部分开发者使用Arduino开发板配合光电传感器构建简易系统。将LED灯与音频信号同步闪烁,通过高速摄像头(240fps以上)记录耳机发声与光信号的时间差。美国声学工程师John Smith在《音频测量实践》中指出,这种方法误差控制在±5ms内,适合产品原型阶段的快速验证。

环境干扰控制

无线信道质量显著影响测量结果。在2.4GHz频段内,Wi-Fi路由器、微波炉等设备会造成频谱重叠。建议在电波暗室中进行测试,或使用频谱分析仪选择干扰最小的信道。日本电信技术委员会TT-2020标准规定,测试环境背景噪声需低于-90dBm,信道占用率不超过15%。

温湿度因素常被忽视。三星电子2022年白皮书披露,当环境湿度超过70%时,蓝牙射频信号的群时延会增大8-12%。建议在25℃、50%湿度的标准环境下进行基准测试,并在报告中注明实际测试条件。

软件分析算法

时域分析法通过比对原始信号与接收信号的波形相似度计算延迟,但易受回声干扰。频域分析法将信号转换至频域进行相位比对,更适合复杂环境。慕尼黑工业大学团队开发的LatencyTracker软件,结合两种算法使测量精度提升至0.5ms。

机器学习为延迟测量带来新突破。阿里巴巴达摩院开发的AudioSync系统,通过训练神经网络识别特定音频指纹,在背景音乐场景下的测量误差比传统方法降低62%。该方法已应用于TWS耳机产线检测,单次检测耗时从20秒缩短至3秒。

行业标准演进

当前主流的ITU-R BS.1387标准主要针对有线设备,蓝牙技术联盟(SIG)正在制定LE Audio标准下的延迟测试规范。草案要求测量需包含设备发现、链路建立等全流程时延,并区分音乐模式(200ms内)和游戏模式(50ms内)两类指标。

中国电子技术标准化研究院2023年发布的《无线耳机性能测试方法》,首次将人体佩戴状态纳入测试变量。标准要求使用仿真人头模型,测量耳道内实际声波传导延迟,这与传统电气信号测量存在3-8ms的系统误差。

蓝牙耳机的延迟测量是涉及多学科的系统工程。从本文分析可见,精确测量需要硬件设备、软件算法、环境控制、标准参照的协同作用。未来研究可向两个方向延伸:一是开发基于人工智能的动态补偿算法,二是建立跨品牌设备的延迟协同标准。随着空间计算时代的来临,对音频时延的测量精度需求将提升至微秒级,这需要整个行业在芯片架构、传输协议等底层技术上的持续突破。

上一篇:如何准确测定高分子材料的软化温度 下一篇:如何准确计算消费者维权过程中的经济成本与时间成本